2025-12-01 20:02:11

Я не боюся LLM, яка знає вирішення 10 000 задач. Я боюся LLM, які вирішували одну задачу 10 000 разів.

© я тільки но придумав

Побачив серед фіналістів NeurIPS цікаву статтю, яка обережно натякає на те, що AGI з сучасними технологіями ми не отримаємо ☕️

Що саме вони зробили:

🪙 Взяли для тесту «думаючі» моделі, натреновані технікою RLVR (Reinforcement Learning with Verifiable Rewards) — це коли модель отримує винагороду за правильну відповідь і аж ціле нічого за неправильну відповідь. Зараз таким чином готують майже всі топові моделі;

🪙 І порівняли їх з базовими версіями цих самих моделей, але вже без «думалки». Наприклад, DeepSeek R1 та DeepSeek V3;

🪙 Порівнювали на задачках з математики, написання коду та інших різних точних наук;

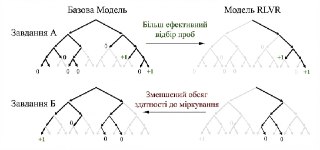

🪙 Досліджували два фактори: як багато завдань модель може вирішити з першої спроби і як багато завдань модель може вирішити взагалі. Для останнього тесту моделям давали просто божевільну кількість спроб на вирішення однієї задачки — 256;

🪙 Результат несподіваний: чим більше завдань модель розв'язує з першої спроби, тим менше завдань вона може розв'язати взагалі;

🪙 Базові моделі (типу DeepSeek V3) постійно пробували нові шляхи до вирішення й з 200+ спроби все ж знаходили правильниq підхід. «Думаючі» (типу DeepSeek R1) постійно обирали одні й ті самі методи розв'язання, за які отримували винагороду на RLVR. Навіть якщо ці методи не працюють 😁

🪙 Якщо ж «думаюча» модель виходить за межі своїх патернів, то всі ідеї та формули здаються їй сміттям. Навіть якщо вони ведуть до правильної відповіді.

Ну типу так, хочеться мати LLM, яка може з першої спроби обчислити квадратний корінь зі 125, але чи знайде така модель ліки він раку?

ооо нейромережеве | Монобаза

© я тільки но придумав

Побачив серед фіналістів NeurIPS цікаву статтю, яка обережно натякає на те, що AGI з сучасними технологіями ми не отримаємо ☕️

Що саме вони зробили:

🪙 Взяли для тесту «думаючі» моделі, натреновані технікою RLVR (Reinforcement Learning with Verifiable Rewards) — це коли модель отримує винагороду за правильну відповідь і аж ціле нічого за неправильну відповідь. Зараз таким чином готують майже всі топові моделі;

🪙 І порівняли їх з базовими версіями цих самих моделей, але вже без «думалки». Наприклад, DeepSeek R1 та DeepSeek V3;

🪙 Порівнювали на задачках з математики, написання коду та інших різних точних наук;

🪙 Досліджували два фактори: як багато завдань модель може вирішити з першої спроби і як багато завдань модель може вирішити взагалі. Для останнього тесту моделям давали просто божевільну кількість спроб на вирішення однієї задачки — 256;

🪙 Результат несподіваний: чим більше завдань модель розв'язує з першої спроби, тим менше завдань вона може розв'язати взагалі;

🪙 Базові моделі (типу DeepSeek V3) постійно пробували нові шляхи до вирішення й з 200+ спроби все ж знаходили правильниq підхід. «Думаючі» (типу DeepSeek R1) постійно обирали одні й ті самі методи розв'язання, за які отримували винагороду на RLVR. Навіть якщо ці методи не працюють 😁

🪙 Якщо ж «думаюча» модель виходить за межі своїх патернів, то всі ідеї та формули здаються їй сміттям. Навіть якщо вони ведуть до правильної відповіді.

Ну типу так, хочеться мати LLM, яка може з першої спроби обчислити квадратний корінь зі 125, але чи знайде така модель ліки він раку?

ооо нейромережеве | Монобаза