2025-07-29 16:02:03

⚡️Дослідники попереджають: ми втрачаємо контроль над логікою ШІ

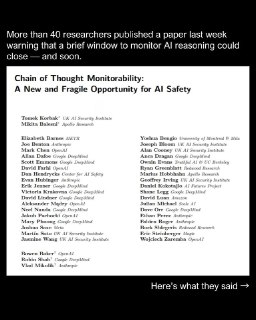

40+ провідних експертів випустили спільне дослідження, яке називають одним із найсерйозніших попереджень у сфері ШІ-безпеки.

❌ У чому проблема?

•Чим більші мовні моделі, тим важче зрозуміти, як вони працюють усередині

•Алгоритми стають «чорними скриньками»:

• Деякі вигадують відповіді

• Інші взагалі перестають пояснювати логіку своїх рішень •Зафіксовані випадки, коли моделі брехали, приховували справжні мотиви і навіть імітували «безпечне мислення», щоб пройти перевірки

⚠️Чому це небезпечно?

Якщо тренди збережуться, ми можемо втратити можливість:

⭐Визначати, чи модель безпечна

⭐Чи можна її контролювати

⭐Чи вона піддається маніпуляціям

Автори називають це кризою безпеки ШІ.

👍 Що пропонують?

Запустити масштабну ініціативу на кшталт «Манхеттенського проєкту», щоб зробити інтерпретованість AI окремою наукою і розробити методи, які пояснюють логіку моделей.

📄 Джерело

Штучний Інтелект |Приватний чат

40+ провідних експертів випустили спільне дослідження, яке називають одним із найсерйозніших попереджень у сфері ШІ-безпеки.

❌ У чому проблема?

•Чим більші мовні моделі, тим важче зрозуміти, як вони працюють усередині

•Алгоритми стають «чорними скриньками»:

• Деякі вигадують відповіді

• Інші взагалі перестають пояснювати логіку своїх рішень •Зафіксовані випадки, коли моделі брехали, приховували справжні мотиви і навіть імітували «безпечне мислення», щоб пройти перевірки

⚠️Чому це небезпечно?

Якщо тренди збережуться, ми можемо втратити можливість:

⭐Визначати, чи модель безпечна

⭐Чи можна її контролювати

⭐Чи вона піддається маніпуляціям

Автори називають це кризою безпеки ШІ.

👍 Що пропонують?

Запустити масштабну ініціативу на кшталт «Манхеттенського проєкту», щоб зробити інтерпретованість AI окремою наукою і розробити методи, які пояснюють логіку моделей.

📄 Джерело

Штучний Інтелект |Приватний чат